这两天围绕 Claude Opus 4.6 的讨论非常密集:一方面是 Anthropic 的官方发布与一系列评测指标;另一方面是媒体与社区对“长上下文 + 更强规划 + 更持久的智能体执行”的真实体验反馈。

如果你想快速判断 Opus 4.6 值不值得上(或该怎么上),这篇文章把当前能查到的公开资料做一次中文梳理:有哪些明确的升级点?哪些数字来自官方、哪些来自第三方榜单?又有哪些说法需要保留态度、等待更多验证?

1) Opus 4.6 到底升级了什么:不是“更会答”,而是“更会做”

在官方介绍中,Opus 4.6 的关键词不是单纯的“更聪明”,而是更偏向智能体能力(Agentic tasks)——它会更认真规划、更能长时间保持任务主线、在更大的代码库里更稳定、并且更擅长代码审查与调试(包括自我纠错)。同时,Opus 级模型首次在 Beta 中提供 1M token 上下文窗口。

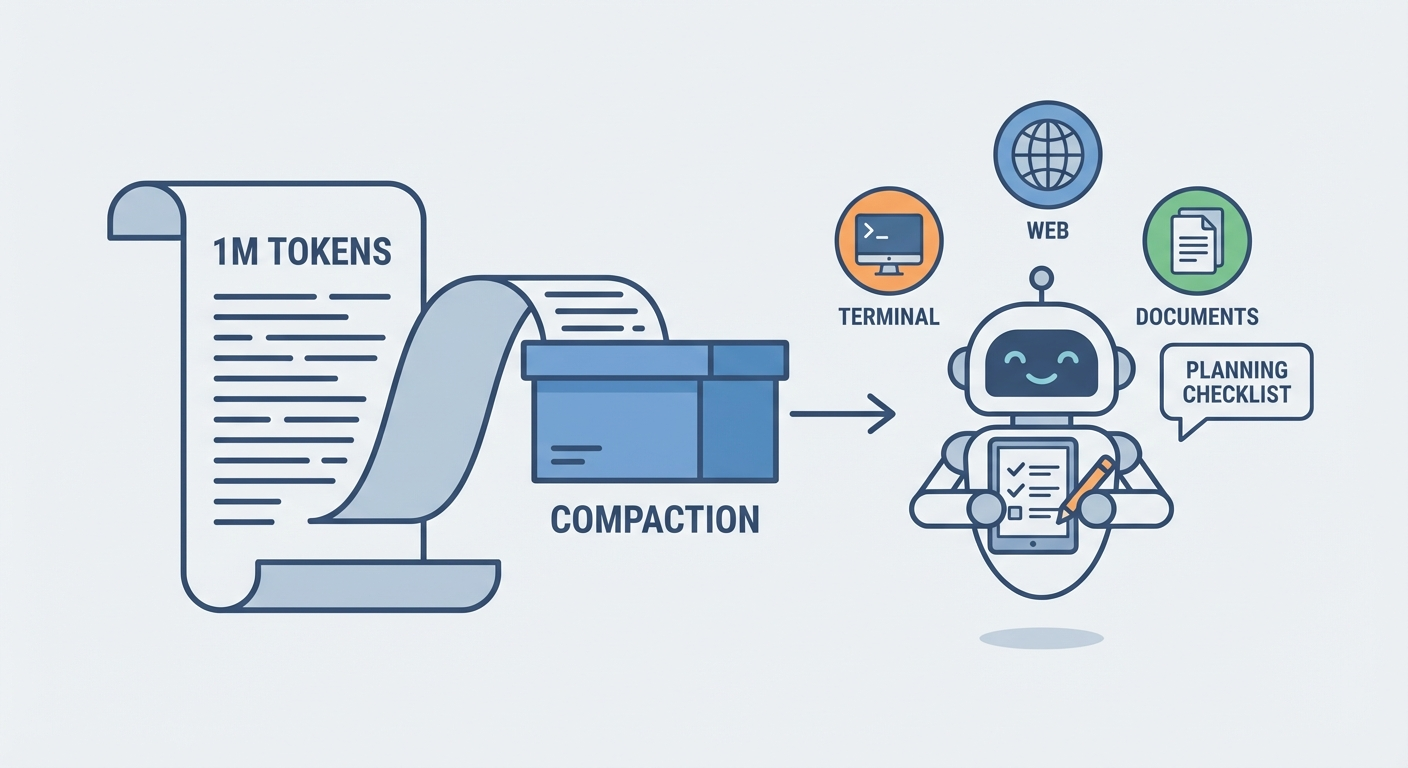

另外一个很容易被忽略的点是“开发者可控性”:Anthropic 在 API 侧补上了一整套长程任务相关能力,比如上下文压缩(compaction)、自适应思考(adaptive thinking)与 effort 控制,让模型在“更深度推理”和“成本/延迟”之间有更可控的拨杆。

来源:

- Anthropic 官方发布: https://www.anthropic.com/news/claude-opus-4-6

2) 评测数据怎么读:官方说它领先,第三方榜单也把它排到第一

2.1 Agentic 编程:Terminal-Bench 2.0

Anthropic 明确宣称 Opus 4.6 在智能体编程评估 Terminal-Bench 2.0 上拿到最高分,并在脚注里说明:他们同时报告了“自家基础设施复现”的成绩以及“其他实验室公开发布”的成绩(具体细节建议以系统卡为准)。

Terminal-Bench 2.0 本身也强调:相比 1.0,它更难、并且做了更强的任务验证,目的是跟上智能体能力的快速进化。

来源:

- Anthropic 官方发布: https://www.anthropic.com/news/claude-opus-4-6

- Terminal-Bench 2.0 公告: https://www.tbench.ai/news/announcement-2-0

2.2 知识工作:GDPval-AA(Artificial Analysis)

在 GDPval-AA(面向金融、法律等“经济价值型”知识工作任务的评估)上,Anthropic 给出的说法是:Opus 4.6 领先“行业次优模型(GPT-5.2)”约 144 Elo,并领先自家 Opus 4.5 约 190 Elo。

与此同时,Artificial Analysis 的 GDPval-AA 排行榜页面也把 Opus 4.6 排在前列(榜单会随评测更新波动,建议以页面实时为准)。

来源:

- Anthropic 官方发布: https://www.anthropic.com/news/claude-opus-4-6

- GDPval-AA 排行榜: https://artificialanalysis.ai/evaluations/gdpval-aa

2.3 在线检索与“能把信息找出来”:BrowseComp

Anthropic 宣称 Opus 4.6 在 BrowseComp(衡量模型“找难找信息”的能力)上表现优于其他模型,并在脚注给出更多运行设置(例如 web_search/web_fetch、工具调用、上下文压缩等)。

BrowseComp 是 OpenAI 开源的 benchmark,强调它衡量的是“浏览/检索智能体的持久性与搜索策略”,而不是简单问答。

来源:

- Anthropic 官方发布: https://www.anthropic.com/news/claude-opus-4-6

- OpenAI BrowseComp 介绍: https://openai.com/index/browsecomp/

3) 长上下文体验:1M token 不是噱头,但“上下文衰减”才是关键

官方对 1M 上下文的叙述比较克制:它强调的是“长上下文下的可用性”,而不仅是“塞得下”。

一个值得关注的细节是,Anthropic 在文中提到常见问题“context rot(上下文衰减)”,并引用了 MRCR v2 的 8-needle 1M 变体:Opus 4.6 得分 76%,而 Sonnet 4.5 仅 18.5%。这意味着在超长对话/超长文档里,Opus 4.6 更有可能持续抓住关键信息,而不是越聊越漂。

但对使用者而言,长上下文带来的另一个现实问题是:成本和延迟会显著上涨。所以 Anthropic 同时提供了“上下文压缩(compaction)”和“effort 控制”,本质上是在帮你把长程任务拆成“信息保留”和“推理强度”两个可控开关。

来源:

- Anthropic 官方发布: https://www.anthropic.com/news/claude-opus-4-6

4) 安全与网络安全:它不仅能写代码,也更擅长找漏洞

这轮 Opus 4.6 的另一个高关注点是网络安全能力。

Anthropic 的安全团队在 2 月 5 日发布的文章里直说:Opus 4.6 在“无任务特制脚手架/无特殊提示”的情况下,也能更快找到高危漏洞;他们进一步提到,团队已经“发现并验证了 500+ 高危漏洞”,并开始向开源项目维护者报告并提交补丁。

对企业与开发者来说,这个信息的意义有两层:

- 正向:更强的“防守型 AI”能力,可能把漏洞发现与修复的效率往前推一大截。

- 反向:如果你的组织把“智能体 + 工具执行”上到了生产环境,风险面也会跟着扩大;需要更严格的权限、审计与使用边界。

来源:

- Anthropic 安全团队文章(0-Days): https://red.anthropic.com/2026/zero-days/

- Anthropic 官方发布(含安全评估与系统卡链接): https://www.anthropic.com/news/claude-opus-4-6

5) 价格与可用性:价格“看起来没变”,但长上下文会触发高级定价

官方信息里,Opus 4.6 在 claude.ai、API 以及主要云平台上可用,并给出基础定价:输入 $5 / 输出 $25(每百万 token)。

同时,在“1M 上下文(beta)”的脚注里,Anthropic 标注了:当 prompt 超过 200k token 时,会触发 premium pricing(输入 $10 / 输出 $37.5 每百万 token)。

换句话说:

- 日常 200k 以内的场景,成本结构与过去类似;

- 真正把 1M 上下文用起来的场景,要提前把预算与延迟纳入设计。

来源:

- Anthropic 官方发布(定价与 premium pricing): https://www.anthropic.com/news/claude-opus-4-6

- IT之家(面向中文读者的整理): https://www.ithome.com/0/919/686.htm

6) 实用建议:什么场景该上 Opus 4.6?怎么用才更划算?

结合官方描述与当前公开资料,如果你主要关心“值不值”,我建议从三个问题切入:

1) 你是否需要长程任务与工具调用?

- 需要:例如代码库级重构、端到端自动化、研究型检索、财务/法务类多源分析 —— Opus 4.6 的定位就是往这里走。

- 不需要:只是日常问答、轻量写作 —— 可能更适合用更便宜/更快的模型,把 Opus 留给关键任务。

2) 你是否经常遇到“上下文越长越崩”?

- 如果你已经被“上下文衰减”折磨过,Opus 4.6 的长上下文可用性提升,可能是一次质变。

3) 你能否把安全边界做扎实?

- 如果你把它当智能体用(能读写文件、能跑工具、能访问系统),请务必默认它是“高权限系统”,先上最小权限、审计、二次确认,再谈自动化。

参考与延伸阅读:

- Anthropic:Introducing Claude Opus 4.6

https://www.anthropic.com/news/claude-opus-4-6

- Terminal-Bench 2.0 announcement

https://www.tbench.ai/news/announcement-2-0

- Artificial Analysis:GDPval-AA Leaderboard

https://artificialanalysis.ai/evaluations/gdpval-aa

- OpenAI:BrowseComp benchmark

https://openai.com/index/browsecomp/

- Anthropic Security:0-Days

https://red.anthropic.com/2026/zero-days/

- IT之家:Claude Opus 4.6 中文整理

https://www.ithome.com/0/919/686.htm

ChatGPT Pro 俱乐部

ChatGPT Pro 俱乐部